<< RETORNAR >>

TEORIA DA INFORMAÇÃO E CODIFICAÇÃO (Aulas iniciais)

O

Pioneiro: Claude Shannon,

por meio da obra “A Teoria Matemática da

Comunicação”,

1948.

• Os dados são qualquer fluxo entre fonte e destino

• A Informação

está associada ao

processo da informação

• O Conhecimento

está associado ao

processamento da informação

Tipos de Fontes

Fonte Contínua: Associada ao sinal analógico

Fonte Discreta: Associada ao sinal digital, transmite

símbolos de um alfabeto

fonte.

Alfabeto

Uma fonte discreta possui um número

finito de símbolos únicos. O

conjunto de símbolos é chamado de alfabeto-fonte.

Exemplo 1

O conjunto das letras maiúsculas

A = {A, B, C, D,... Z}

Exemplo 2

O conjunto das letras maiúsculas,

minúsculas e numerais.

A

= {A, B, C,... X, Y, Z, a, b, c,... x, y, z, 0, 1, 2,... 7, 8, 9}

O número de elementos de um alfabeto A

é chamado de

cardinalidade e designado por |A|. Um alfabeto de n letras

sobre A é chamado um n-grama

sobre A. A partir

de um alfabeto podemos

gerar um novo

alfabeto pela construção de n-gramas

sobre o alfabeto original obtendo um alfabeto extensão.

Seja A={a0, a1, a2,... am-1} onde |A| = m. Podemos

gerar A2

contendo m2 2-gramas tal que A2={a0a0, a0a1, a0a2,... am-1am-1}. Generalizando, concatenando-se n letras de A obtemos

o alfabeto An contendo mn n-gramas de A.

Exemplo

Considere o alfabeto A = {A, B,

C,... Z}

• Podemos dizer que UNIRON é um 6-grama

sobre o alfabeto A.

Considerando o alfabeto A3 = {AAA, AAB, AAC,... ZZZ}

• Podemos dizer que UNI

RON é um 2-grama sobre o

alfabeto A3. Observe-se

que não se trata de separação silábica, e sim a codificação proposta ao alfabeto.

Considerando o alfabeto conjunto das

instituições de ensino superior

• Podemos dizer que UNIRON é um 1-grama

Associações

A -> Z

O Alfabeto A foi associado ao

conjunto dos inteiros

|

A |

B |

C |

... |

X |

Y |

Z |

|

0 |

1 |

2 |

... |

24 |

25 |

26 |

Quantidade de

Informação

Hartley

escreveu em 1923 o arquivo que inaugurou a “Teoria da Informação”

Shannon

em 1948 descobriu que a função log pode medir a

quantidade de Informação.

Suponha E1 e E2 dois eventos com probabilidades de ocorrência p1 e p2. É de se esperar que a quantidade de informação obtida pelo

conhecimento da ocorrência de ambos os eventos possa se relacionar ao

conhecimento individual da ocorrência de cada evento I(E1 E2) = I(E1) + I(E2), caso E1 e E2

sejam

independentes.

![]()

A equação

acima nos dá a medida de informação resultante da ocorrência de um determinado

evento E com probabilidade p(E).

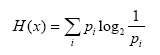

Entropia

Dada uma

variável aleatória x, a qual pode assumir um número finito de valores

possíveis xi,

1 ≤ i ≤ n, com probabilidades pi associadas a cada um destes valores, e ∑ = 1 i p ,

denominamos de entropia, designada por H(x), a

esperança matemática para a quantidade de informação contida em um evento

possível qualquer.

"Quanto maior a quantidade de informação, menor a

certeza!!!"

<< RETORNAR >>